Budoucnost patří umělé inteligenci. Takovou představu mohl člověk získat při sledování médií v posledních měsících. V mnoha oblastech se to zřejmě opravdu stane, v té právní to tak ale zatím příliš nevypadá. Potvrzuje to ostatně i nová studie vědců ze Stanfordovy univerzity, která zjistila, že specializované právní nástroje využívající takzvané velké jazykové modely stále trpí značnou mírou halucinací neboli výstupů, které jsou prokazatelně nepravdivé.

„Nástroje umělé inteligence jsou náchylné k právním halucinacím – mají sklon vymýšlet si falešná fakta, případy, rozhodnutí, zákony a předpisy,“ řekl webu VentureBeat profesor práva na Stanfordu a spoluautor studie Daniel E. Ho. Výzkumníci navrhli různorodý soubor právních dotazů a testovali je na třech předních nástrojích pro právní výzkum poháněných umělou inteligencí: Lexis+ AI společnosti LexisNexis, Westlaw AI‑Assisted Research a Ask Practical Law AI společnosti Thomson Reuters. Studie zjistila, že všechny tři nástroje sice dosahují výrazně lepších výsledků než průkopnický GPT‑4 od OpenAI, ale zdaleka nejsou dokonalé, protože halucinují u 17 až 33 procent dotazů.

Při čtení této studie jsem rychle pochopil, proč na mě tolik advokátů při dotazu, zda využívají umělou inteligenci ve své praxi, poněkud shovívavě pohlédlo a opáčilo – při tvorbě marketingových textů na sociální sítě možná ano, ale v právu?

Zaujal vás článek? Pošlete odkaz svým přátelům!

Tento článek je odemčený. Na tomto místě můžete odemykat zamčené články přátelům, když si pořídíte předplatné.

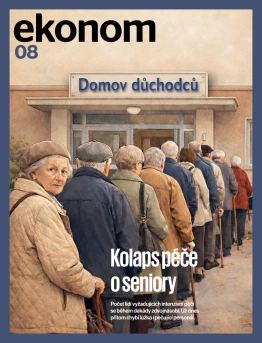

Aktuální číslo časopisu Ekonom

Aktuální číslo časopisu Ekonom

Petr Kain

Petr Kain